Leap Motionの仕組み、全プロダクトの技術を調べてみた。

VR/ARと切っても切り離せない関係にあるハンドコントロール技術。

コントローラーではなく、自らの手を媒介にするため、仮想空間への没入感が強化される事が明らかになりつつある今日この頃ですが、今回はそのハンドトラッキング技術にコアコンピタンスを持つLeap Motionの全容をプロダクト群に沿って解説していきます。

Leap Motionのコア技術

Leap Motionは、手の動きを通じてVR空間やPC画面を操作するデバイスを開発するアメリカの開発会社です。

まずはこちらの動画をご覧ください。

ちょっとエグい動画から入りましたが、非常に近未来的なユーザーインターフェースを実現している同社。

創業は2010年とAR/VR会社の中では比較老舗の部類で、Leap Motionは創業以来マウスやコントローラーを使わずにデジタル空間を操作するためのデバイスを開発しています。

上の動画のように、ユーザーのアクションにリアルタイム反応するAR映像を作る仕組みとしては大きく分けて2つのコア技術が必要です。

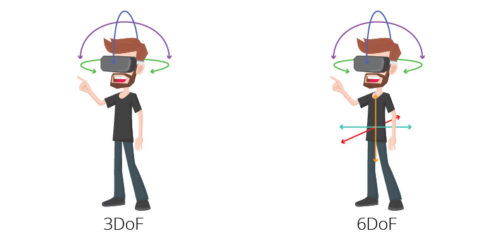

1つ目は、トラッキング技術(瞬時に手の位置を測定する技術)

2つ目は、リアルタイム映像生成技術(手の位置のデータに合わせたAR映像を瞬時に描き出す技術)

Leap Motionは上記2つの手のハンドトラッキング、リアルタイムの映像生成という点においては、他社にはない技術的な強みを持っています。

Leap Motionのプロダクト群

Leap Motionは創業当初、PC用のモーションコントローラー「Leap Motion Controller」を開発していました。

Leap Motion Controllerの解説は後ほどしますが、現在では自社内でARヘッドセット(呼称:Project North Star)を開発したり、VRHMDの開発パートナー会社向けにモーショントラッキングを導入できるSDKを提供していたりと、事業モデルは多岐に渡ります。

ここからはLeap Motionのプロダクトを1つずつ解説していきます。

Leap Motion Controller(2013年発売)

Leap Motion Controller shipping to customers starting May 13, pre-orders available at Best Buy now pic.twitter.com/WH92ToIdbx

— Adrian Ortega (@TechFilmSavvy) 2013年2月27日

本体のサイズはW80×D30×H11mmとかなり小型のハードウェア。

Leap Motionが一躍有名になった最初のプロダクトとして知られており、Leap Motion Controllerの上で手を動かすとセンサーが反応し、PC画面をマウス無しで操作することが可能になっています。

仕組みとしては、ハードウェア本体の中央/左右の3カ所に立体認識のため2つのレンズがあり、CMOSイメージセンサーで処理されます。(CMOSイメージセンサーとはデジタルカメラで画像を記録するために使われている部品)

つまりLeap Motion Controllerは2台の赤外線カメラを用いてかざされた手を3D撮影し、その画像から手や指の位置、動きを解析し、PC画面に反映するというのが大まかな仕組みとなっています。

Project North Star(2018年3月発表)

Project North Starは、Leap Motionが初めて自社開発したARヘッドセットです。

これは一般向けへの販売を想定して開発されたものではなく、あくまでプロトタイプであり、Leap Motionの技術を分かりやすくデモンストレーションするために作られた製品とされています。(そのためデザインに拘りは感じられず、少々昆虫っぽいと揶揄されがちです)

まさにアイアンマンの世界がすぐそこに!

こちらの動画を見るとAR時代の新しいインタフェースがどのような形になるか、鮮明にイメージできるようになっています。

同社曰く、量産化によって価格としては100ドルほどでの販売が可能とのことですが、これは光学系の仕組みやデザインを単純化したことによって実現しているようです。

ちなみにLeap MotionはこのNorth Starの設計図を公開しています。関連ファイルは公式サイト(英語、要サインイン)または、Github(英語)に格納されています。

今後の同社の戦略としてProject North Starの技術をオープンソースで公開し、様々なVR/ARのハード/ソフトの実用化を効率化する開発プラットフォームになることを目指しているようです。

Interaction Engine

次はVRアプリの開発補助ツール「Interaction Engine」を紹介します。

Interaction EngineはVR空間で、現実世界に近い物理法則を再現することができる開発エンジンです。

現実の世界では重力があり、ボールを投げれば落ちますし、物体同士が衝突すると物理学の法則に従いますが、VRの世界に物理法則は存在せず、開発者が作った設計ロジックに従います。

ユーザーの体験を現実世界に近づけるためには、物を投げた時の重力加速度は現実と同じように働かなければなりませんが、そういった作業を簡素化するのがこのInteraction Engineです。

@LeapMotion your new Interaction Engine in #unity3d is fun! pic.twitter.com/2FHwrMXq9N

— Rory Shafto (@RoryShafto) 2016年8月25日

同社はInteraction Engineのメイン機能として3つ挙げています。

⑴、Contact(接触):物体と触れた時、物体はどのように動くべきか?壊れるのか?通り抜けられるのか?

⑵、Grasp(掴む):物体を掴んだり離したりするときの挙動、動き方の適切な見せ方は?

⑶、Hover(かざす):今触れようとしてる物体が、本当に触りたい物体かどうか判別するために、どのように適切に伝えるか?

ユーザの立場からすれば、VRアプリ毎に操作の感覚が違うと慣れるまでに時間がかかってしまいますし、ストレスを感じてしまう可能性もあります。

Interaction Engineには優れたUIモジュールが組み込まれており、デベロッパーは自分が作りたいアプリやゲームの重要な機能に集中して開発する事ができるのです。

Orion

OrionはLeap MotionがVRに特化したソフトウェアプラグインでVRヘッドセットと使用することを念頭に設計されたハンド・トラッキングエンジンです。

Leap Motion Orion 3.1。確かに手を組んでも認識される。凄い。 pic.twitter.com/rz3C17HPjT

— ザバイオーネ@めぐるーま (@z_zabaglione) 2016年3月1日

VRのソフト開発者は、このOrionのSDKをインストールすることで検出精度の高いモーショントラッキング機能を実装することが出来ます。

Orion(ベータ版)のダウンロードはこちらから

現段階において、VR空間との接点の持ち方はOculus TouchやSteam VRコントローラー、PS Moveなどデバイスを使う方法が主流です。

しかしコントローラーを介さずに直接、手を使って仮想空間の物質と触れ合うことが出来るという体験はユーザーの没入感をより強化するため、将来的にVR空間での活動はLeap Motionが目指すデバイスフリー型が主流になっていくとも言われています。

Looking Glassと組み合わせて3Dホログラムに介入できる

「Looking Glass」はアメリカのLooking Glass Factory社が開発した3Dホログラムディスプレイです。

※参考記事 ) 90%の人が間違えてる!「ホログラム」・「ホログラフィ」ってどんな技術?

この「Looking Glass」のすごいところは、単に3Dモデルのホログラム映像を表示できるだけでは無く、3Dモデルの映像に擬似的に触って『介入』することもできます。

ホログラムスクリーンやばい!中身に触れる!これすげえ!のぶミニ個展で展示しますよー!

裸眼立体だけじゃなく触れる(擬似的)。CGに関与してるかんじすげえ!このイベントで展示しますー。https://t.co/TdGOtzTCaa pic.twitter.com/RbJGbgSZjt— のぶほっぷ福井信明wf2019w【4ー23ー08】 (@nobgame) 2018年7月18日

『触れる立体CG』ってなんだかワクワクしますよね!

「Looking Glass」のホログラム技術を利用すれば、さらに色々な使い方が出てきそうです。

これは「インタラクションアクセサリーパック」を入手すれば、 Leap Motionコントローラーを使い、ハンドジェスチャーで3Dモデルと接触することができます。

Looking Grassが気になる方はこちら→)未来過ぎる3DデバイスLooking Glassの仕組みや使い方、購入方法を解説!

まとめ

いかがでしたでしょうか?

同社のCTOが言うように、VR/ARはまさにデジタル世界と現実空間を繋ぐ窓口であり、コンピューターと現実の融合は今後も更に進んでいく事が想定されます。

その時のインタフェースにLeap Motionが提供するハンドトラッキングがどれほど影響を与えているのでしょうか?今後もXR-HubではLeap Motion の動向に着目していきたいと思います。

この記事はいかがでしたか?

もし「参考になった」「面白かった」という場合は、応援シェアお願いします!